极端天气等恶劣环境下的智能视觉识别技术在气象灾害预警、汽车自动驾驶、无人机远程控制等领域具有广阔的应用前景。由于常规观测数据包含了许多人工智能视觉模型无法预测的噪声信息(例如雾、雪和夜间低光环境等),为了解决这一问题,无监督领域自适应(Unsupervised Domain Adaptation, UDA)已成为当前主流的技术方法。然而,过去大多数基于UDA的视觉模型在训练后只能适应一种特定的气象条件,无法满足实际应用中复合极端天气(例如雨夹雪的夜晚)的场景需求。

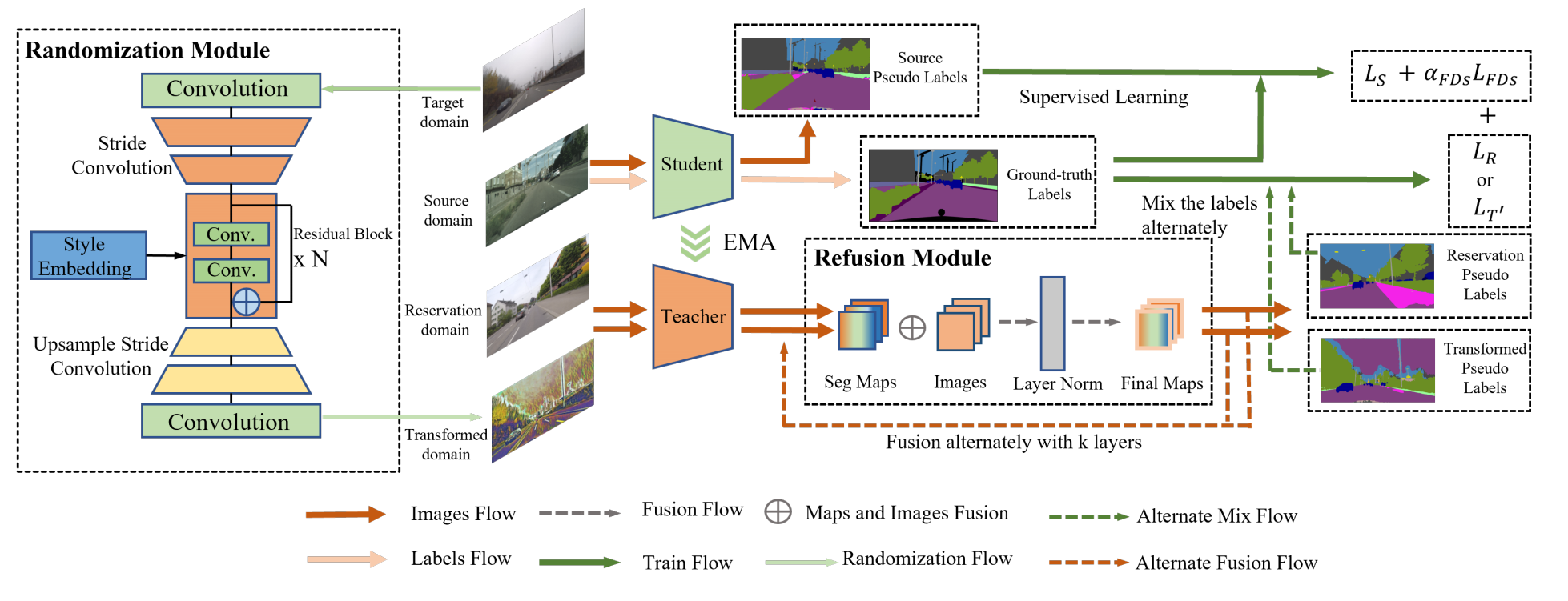

针对以上难点,本研究专注提升UDA模型在多种极端天气下的泛化能力,提出了一个全新的视觉模型(图1)。与以往的UDA模型不同,该模型采用了一种新颖的风格增强方法,并引入了一个新的中间域作为连接多种极端天气场景的桥梁。同时,该技术还包含了一种全新的特征融合操作,用于增强对极端天气场景进行细粒度的特征提取。该模型仅需使用一种气象条件(例如雾)的观测数据进行训练,就能够适应到雾、雨、雪、沙尘等多种复合场景。图2中展示了本研究设计的视觉模型STA对于街道场景的识别效果,以最右边的真实标签值为参照,STA模型对于极端天气条件下道路、建筑等物体的识别效果明显优于以往的UDA模型。

图1 算法流程图

图2 实验结果(最左侧为真实图像,最右侧为真实标签值,中间四列分别代表主流的DAFormer模型,以及STA模型的消融模块Radom-only,Radom-Reserve和STA模型)

研究论文 Train One,Generalize to All:Generalizable Semantic Segmentation from Single-Scene to All Adverse Scenes 被美国计算机协会(Association for Computing Machinery, ACM)第31届国际多媒体大会(ACM International Conference on Multimedia,ACM MM 2023)录用(CCF A类会议)。中山大学大气科学学院硕士研究生龚子洋为论文第一作者,我实验室地球系统模式创新团队核心成员吉振明副教授为论文共同通讯作者。本届大会于2023年10月29日至11月2日在加拿大渥太华召开,大会有效投稿量达3072篇,接收论文902篇,录用率为29.3%。该成果得到了南方海洋科学与工程广东省实验室(珠海)创新团队建设项目的支持。

原文链接:https://dl.acm.org/doi/10.1145/3581783.3612387